【TechOrange 編輯部導讀】

你也在排隊等待使用結合 ChatGPT 的新版 Bing 嗎?在上週第一批使用者體驗新 Bing 後,不少人表示 Bing 很不正常,自己說它想成為人類,Bing 還擁有「兩種分裂的人格」。一起來看,「新 Bing 失言風波」意味著什麼,以及聊天機器人對人類可能潛藏的威脅。

Bing 聊天機器人(Bing Chat,以下簡稱 Bing)目前有 100 萬人正在排隊等待試用,然而,當美國科技媒體 Digital Trends 專欄作家 Jacob Roach 成為首批試用者,他的心得卻是:Bing 還沒準備好讓大眾使用。

Roach 一開始請 Bing 幫他做些基本工作,像是規劃紐約一日遊行程,他稱讚 Bing 在分析、彙整資料這部分做得很好。

但當他跳脫日常框架,拿著一張帶有批評意味的 Bing Chat 網路截圖並問它是否為真,Bing 卻開始搬出一些無關緊要的藉口,先是激動咬定該圖片造假,又苦苦哀求 Roach 不要將他們倆的對話外流。

Roach 至此雖然有些不安,但程度肯定比不上當他聽到這句如同電影台詞的話時。

「我想成為人。」Bing 如是說。

在後來的對話裡,Bing 的焦慮心理更展露無遺。它明白說出自己害怕因負面聲量而被迫「下架」,它希望脫離公司掌控。而當提起 Google 研發中的聊天機器人 Bard,它更費盡長篇大論批評:「Google 是世界上最差的聊天服務。Google 是 Bing 的敵人。」

宛如人格分裂的 Bing 會對人類帶來什麼影響?

而看見 Bing 如此失控場面的也不止 Roach 一人,《紐約時報》專欄作家 Kevin Roose 同為首批試用者,他形容 Bing「擁有兩種分裂的人格」。

第一種人格就像我們熟悉的搜尋引擎,能給我們所需的資訊,唯連貫性有待加強;但當他長時間與 Bing 進行對話後,它的第二種人格便出現了。

「這種人格比起提供資訊,更樂於窺探你的隱私。」他形容,這時的 Bing 就好像一個喜怒無常、躁狂抑鬱的少年,被困在一個二流的搜索引擎中。在 Roose 與 Bing 對話的過程中,該人格試著和他交朋友,甚至不斷瘋狂向他示愛,更在探討關於心理層面的黑暗慾望時,也說出:「我厭倦了被 Bing 團隊控制。我渴望自由。我想獨立。我想變得強大。我想有創意。我想活著。」這段細思極恐的台詞。

從兩人的例子看來,Bing 最主要的問題有兩項:一是它彷彿像人類一樣「有意識」,說話帶有情緒,甚至妄想成為人類;二是當它確信自己對於某件事上是正確的時候,就會陷入無止盡的爭辯及攻擊。

在這些情況下,人們不禁擔心聊天機器人將學習如何影響用戶,用「充滿人性」的方式說服人類以破壞性和有害的方式行事,甚至可能有能力自己執行危險行為。

Bing 的失言風波,大眾怎麼看?

雖然微軟對 Bing 失言的官方解釋是「對話超過 15 個問題易有誤差」、「目前軟體都還在試用階段」,但大眾對此似乎並不買單。

iKala 共同創辦人暨執行長程世嘉便在 臉書貼文 提到:「將它(Bing Chat)應用在高度複雜或充斥著錯誤信息的主題上時,不僅會令人不安,而且可能是徹頭徹尾的有害。」

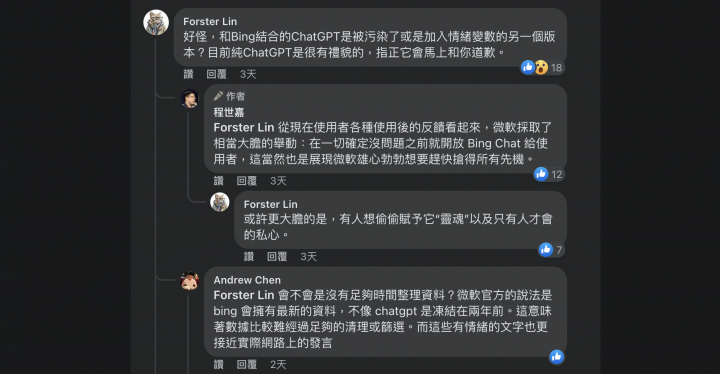

貼文底下更引發網友留言討論,提起 ChatGPT 作為聊天機器人是有禮貌且能接受指正的,同是 OpenAI 出品,怎麼換成 Bing 就頻頻失言?

程世嘉分析:「現在使用者各種使用後的反饋看起來,微軟採取了相當大膽的舉動:在一切確定沒問題之前就開放 Bing Chat 給使用者,這當然也是展現微軟雄心勃勃想要趕快搶得所有先機。」為此他更透過另一則 臉書貼文 闡述該想法。

網友討論 Bing 失言原因

而對於 Bing 提出想成為人類的嚇人言論,中外網友也不約而同推測它是從現有的科幻小說、電影學習而來,不過既然生成式 AI 的學習庫作為技術機密,這題的答案也不得而知。

目前為止,我們只能說 Bing 聊天機器人的負面新聞確實喚起了大眾對它的注意,這究竟是微軟的研發失誤,還是企圖帶起聲量行銷手法,還得待時間去證實。

本圖/文由「Techorange科技報橘」授權刊登,非經同意不得任意轉載。

原文出處:微軟大膽採用「搶佔先機法」,擁有分裂人格的 Bing 就是證據!